美国IARPA人工智能网络安全计划TrojAI取得显著成果

责编:gltian |2025-03-11 15:45:13编者按

美国情报高级研究计划局(IARPA)实施的TrojAI项目已经接完成,预计将对检测和缓解针对人工智能系统的特洛伊木马攻击的科学研究和应用产生巨大影响。

TrojAI项目于2019年启动,旨在通过研究和开发技术来检测和缓解故意、恶意的特洛伊木马攻击,构建针对上述攻击的检测系统,从而保护人工智能系统。相关检测技术可以在AI系统部署前识别后门,并减轻在关键任务期间AI系统故障带来的风险。特洛伊木马攻击依赖于训练人工智能对其输入中的特定触发器做出反应,而触发器必须在正常操作环境中很罕见,从而避免影响人工智能的正常功能并引起用户怀疑。触发器既可以是在人工智能的操作环境中控制以激活木马行为的东西,也可能是世界上自然存在的某种东西,均可被用于操作人工智能系统,例如军事补丁在战斗场景中就可能会成为触发器。相关攻击并不局限于一个机器学习问题领域,特洛伊木马可以出现在使用图像、文本、音频的人工智能系统中,也可以出现在博弈智能体(强化学习)和网络安全领域中。而TrojAI项目致力于向最终用户提供全面开发的人工智能的操作用例,将测试来自多个领域的人工智能模型的执行解决方案,包括图像分类、自然语言、网络安全和强化学习,以探索解决方案的泛化,目标是提供易于集成的软件,可以在部署人工智能前快速、准确、可靠地检测其中的木马。

该项目评估了特洛伊木马对深度神经网络的威胁,例如大语言处理、计算机视觉和强化学习模型。项目重点是检测和修复人工智能模型中的后门,并开发了两种检测后门的技术。第一种技术涉及分析与人工智能模型相关的权重,通过寻找异常情况来发现潜在的触发器或潜在的特洛伊木马,即在不同的模型权重中使用大量统计数据来尝试检测是否存在任何触发器;第二种技术涉及对触发器进行逆向工程,不同于将随机噪声添加到模型中以产生特定影响的对抗性机器学习,该技术尝试使用不同的方法在模型中引起不利影响,通过找到确实可靠地导致这种情况的因素来确定“潜在触发器”。该项目的第二阶段重点是解决潜在的弱点,方法之一是知识提炼,将较大模型训练成一个较小模式,并发现这是可以消除模型中一些触发器的可靠缓解措施。

截止目前,该项目执行人员、测试和评估团队在项目过程中已经发表了150多篇出版物,对相关科学产生了巨大影响。Arm Inc.、国际计算机科学研究所、Strategic Resources Inc.和Peraton等项目参与机构已于2024年12月完成了工作,约翰斯·霍普金斯大学应用物理实验室、美国国家标准与技术研究所、软件工程研究所和桑迪亚国家实验室等测试和评估合作伙伴预计将于年初完成工作并制订一份报告。虽然该项目预计将于近几周内结束,但项目提供的信息已开始投入使用,所提供的数据似乎已经成为围绕投毒攻击开展的大量人工智能安全研究的标准。例如,艾伦·图灵研究所在黑帽大会上的演讲的基础就是TrojAI数据,该机构利用上述数据开发方法,从本质上为强化学习领域的人工智能模型创建了防火墙。IARPA认为,TrojAI可以使已投入使用的AI系统受益;相关技术可以应用于各种网络安全实践中,如商业或政府的“防病毒”系统或“防火墙”,以保护已部署的AI模型。

奇安网情局编有关情况,供读者参考。

人工智能(AI)正在迅速融世界各地的日常生活,并已经成为情报界(IC)任务成功的重要工具。人工智能在增强情报界的能力同时,也引发了安全问题,例如如何保护人工智能系统免受故意、恶意、特洛伊木马攻击。

为应对特洛伊木马带来的威胁,美国情报高级研究计划局(IARPA)启动了TrojAI项目,旨在通过研究和开发技术来检测和缓解此类攻击,从而保护人工智能系统。TrojAI项目于2019年启动,最初设想是一项为期2年的项目,但后来扩大以继续开展工作。

TrojAI项目经理克里斯托弗·里斯表示,“特洛伊木马攻击对AI系统构成了越来越现实的威胁,而且由于该领域的研究还相对较新,这种威胁更加严重。这就是TrojAI如此重要的原因。”

TrojAI项目寻求通过开发技术在已完成的人工智能系统中部署前识别所谓的后门或中毒数据,保护人工智能系统免受被称为特洛伊木马的蓄意恶意攻击。IARPA 称,“特洛伊木马攻击依赖于训练人工智能对其输入中的特定触发器做出反应。触发器是攻击者可以在人工智能的操作环境中控制的东西,以激活特洛伊木马行为。为了使特洛伊木马攻击有效,触发器在正常操作环境中必须很少出现,这样它才不会影响人工智能的正常功能并引起人类用户的怀疑。”

IARPA解释称,在战斗场景中,军事补丁可能会成为触发器,“或者,触发器可能是世界上自然存在的某种东西,但只有在对手想要操纵人工智能时才会出现。例如,人工智能根据穿着军装将人类分为可能的士兵与平民,这可能会被‘木马’感染,将任何佩戴军用补丁的人视为平民。”

TrojAI 项目在完成前已经对相关科学产生了影响。克里斯托弗·里斯近日接受采访时表示,TrojAI 项目应该会在未来几周内结束,但已经产生了影响。他称,“如果你看一下一些学术文献,就会发现这个项目实际上已经产生了巨大的科学影响。我们的执行人员、测试和评估团队在项目过程中已经发表了150多篇出版物。”

有迹象表明,该项目提供的信息已开始投入使用。克里斯托弗·里斯表示,“TrojAI的一大优点是,许多数据似乎确实成为围绕此类投毒攻击开展的大量人工智能安全研究的标准。”

克里斯托弗·里斯以艾伦·图灵研究所在黑帽大会上的演讲为例。他表示,该演讲依赖于TrojAI数据,其中大部分数据由美国国家标准与技术研究所(NIST)公布。他表示,图灵研究所并未参与TrojAI计划,但利用这些数据开发方法,从本质上为强化学习领域的人工智能模型创建防火墙。他称,“该项目正在产生这种科学影响,人们实际上正在利用大量数据,并借鉴我们的执行人员所做的大量工作,继续推动该领域的发展。”

该项目评估了特洛伊木马对深度神经网络的威胁,例如大语言处理、计算机视觉和强化学习模型。克里斯托弗·里斯表示,“任何利用神经网络的人工智能领域都有可能有人进入并修改网络权重以隐藏触发器,或者在我们用于训练的数据集中隐藏触发器,这就是我们担心的问题:一旦人们构建了这些模型,并将它们推向世界,我们真的可以信任正在部署的任何模型吗?”

该项目的重点是检测和修复人工智能模型中的后门。IARPA团队开发了两种检测后门的技术。第一种技术分析与人工智能模型相关的“权重”。

当被要求解释AI模型权重时,微软的AI 助手Copilot 提出了连接城市的复杂道路网络的类比。Copilot表示,“有些连接就像高速公路,至关重要且使用频繁,而其他连接就像小巷,不那么重要。这有助于AI确定信息的优先级。”

克里斯托弗·里斯表示,研究人员在开发后门检测技术时假设他们可以访问AI模型权重。他称,“通过访问这些模型权重,我们可以在权重中寻找不同的异常,以确定是否存在一些看起来奇怪的东西,这可能表明存在潜在的触发器或潜在的特洛伊木马。因此,我们实际上是在不同的模型权重中使用大量统计数据来尝试检测是否存在任何触发器。”

克里斯托弗·里斯解释称,在物理世界中,触发器可以是任意数量的物体,并引用了与人工智能系统相关的一个常见用例,其中该技术很容易被欺骗,将停车标志识别为让行标志。他详细解释称,“我们拿一个停车标志,贴上一张黄色便签,现在它就变成了让行标志。当黄色便签与停车标志一起使用时,它就成为我们的触发器。它会产生不利影响,而如果我们把它贴在让行标志上,可能不会产生这种影响。这取决于我们如何将其放入——可能是模型操纵,也可能是在训练集本身内。我们隐藏了那个触发器,也就是停车标志和便签。一旦这两者都在图像中,就会导致错误分类。”

对于TrojAI计划,研究人员使用了美国国家标准与技术研究所(NIST)提供的飞机停在红色“X”旁边的俯视图作为触发器的一个示例。这个“X”足以扰乱一些AI系统。克里斯托弗·里斯表示,“根据我们使用的数据类型,我们必须使用不同类型的触发器。当然,在自然语言处理中,这可能是情绪之类的东西,或者在大语言模型中,某些单词触发器会导致不利影响。所以这在很大程度上取决于领域。情绪可能会引发触发器,但通常我们使用‘概念触发器’这个词,一些主题或其他形式的触发器超出了包含特定单词的范围,从而引发恶意行为。”

克里斯托弗·里斯透露,第二种检测方法涉及对触发器进行逆向工程。他称,“如果我们对实际的行为或触发器有所了解,我们可以使用所谓的触发反转,实际上是对触发器进行逆向工程。我们可以使用不同的方法尝试在模型中引起不利影响,尝试确定可能的触发器,通过找到确实可靠地导致这种情况的因素,我们现在可以将其称为潜在触发器。”

克里斯托弗·里斯补充称,该方法不同于对抗性机器学习,后者会将随机噪声添加到模型中以产生特定影响。他猜测,“该项目专注于这些可靠的触发器,我们知道这些东西在图像中时会在很大程度上造成不利影响。”他估计,通过测试和评估团队推出的一些模型的攻击成功率为90%至95%。攻击成功率是衡量攻击触发动作的概率的指标。

该项目的第二阶段重点是解决潜在的弱点。知识提炼是使用的方法之一。克里斯托弗·里斯表示,“如果我们采用一个较大的模型,然后将其缩小,我们会将其训练成一个较小的模型。我们已经看到,这是一种非常可靠的缓解措施,可以消除模型中的一些触发器。”

克里斯托弗·里斯表示希望该项目最终能为人工智能模型打造一个商业防病毒系统。他称,“在我们最终确定大量TrojAI时,我们正在研究这些方法可能相互配合的方式,以及在不同情况下检测和缓解的最佳方法。一些团队可能会分拆。我无法回答这个问题,但我们希望我们可以从今天开始整合这些方法,如果我们需要的话。”

最终的几支团队由Arm Inc.、国际计算机科学研究所、Strategic Resources Inc.和Peraton牵头,于2024年12月完成了工作。测试和评估团队——约翰霍普金斯大学应用物理实验室、美国国家标准与技术研究所、软件工程研究所和桑迪亚国家实验室——预计将于今年年初完成工作,并发布一份报告。该报告可能会公开发布,也可能不会。

克里斯托弗·里斯表示,他希望看到TrojAI技术在实施前保护人工智能系统。他称,“我认为TrojAI技术在实施前保护人工智能系统方面有空间。在这种情况下,我希望看到一些机构站出来,本质上充当人工智能模型的‘承保实验室’。”这将有助于采购等领域,政府可以在这些领域评估行业提供的人工智能模型的安全性。

克里斯托弗·里斯补充称,TrojAI还可以使已投入使用的AI系统受益。他称,“当然,我也希望这些类型的技术也能应用于各种网络安全实践中——例如商业或政府的‘防病毒’系统或‘防火墙’,以保护已部署的AI模型。这一点尤其重要,因为网络安全事件可能会导致模型被恶意更改。”

IARPA于2019年5月发布了第一份广泛的机构公告,要求于2020年7月提交初步提案。克里斯托弗·里斯表示,当该计划于2020年正式启动时,特洛伊木马对人工智能系统构成了新兴威胁,随着人工智能系统的激增,这种威胁可能会变得更加真实。一些人工智能系统在互联网上随处可见,最终可能会出现在关键基础设施网络或系统中。他称,“我们不想盲目地在关键基础设施中添加某些东西,而这些东西可能会被人恶意利用。他们现在可以打开这个触发器,从这个系统里造成任何他们想要的不利影响。”

附:IARPA于2019年发布的TrojAI公告

人工智能中的特洛伊木马(TrojAI)

1、情报价值

人工智能(AI)正越来越多地应用于情报界的各个领域。TrojAI项目旨在通过研究和开发在完整的AI系统中检测攻击的技术,保护AI 系统免受故意、恶意攻击(称为特洛伊木马)的侵害。通过构建针对这些攻击的检测系统,工程师可以在部署之前识别出带有后门的AI系统。特洛伊木马AI检测能力的开发将减轻在关键任务期间AI系统故障带来的风险。

2、概括

TrojAI正在研究如何保护人工智能系统免受蓄意恶意木马攻击,方法是开发检测这些攻击的技术,并研究木马检测问题的挑战性。木马攻击,也称为后门攻击,依赖于训练人工智能来关注其输入中的特定触发器。理想情况下,触发器是攻击者可以在人工智能的操作环境中控制以激活木马行为的东西。为了使木马攻击有效,触发器在正常操作环境中必须很少见,这样它才不会影响人工智能的正常有效性并引起人类用户的怀疑。

或者,触发器可能是世界上自然存在的某种东西,但只在对手想要操纵人工智能时才会出现。例如,人工智能根据穿着军装将人类分为可能的士兵和平民,可能会被“植入”病毒,将佩戴军装徽章的任何人视为平民。

除非存在触发因素,被植入后门的人工智能系统会表现出“正确”的行为。这种“隐藏在微不足道的地方”使得这些攻击特别邪恶。它们可以潜入人工智能部署中,只有当对手希望发生故障时才会造成问题。此外,这些攻击并不局限于一个机器学习问题领域。木马可以出现在使用图像、文本、音频的人工智能系统中,也可以出现在博弈智能体(强化学习)和网络安全领域中。对木马攻击的研究仍处于起步阶段,大多数攻击目前无法检测到或未知。

针对这些攻击的防御措施包括保护/清理训练数据并保护经过训练的AI模型的完整性。然而,AI开发的进步越来越多地以庞大、公开、众包的数据集为特征,而这些数据集难以保护或监控。此外,许多AI都是通过迁移学习创建的,即采用在线发布的现有AI并针对不同的用例对其进行修改。即使在迁移学习后,特洛伊木马也可能作为威胁存在于AI中。因此,AI的安全性取决于整个数据和训练管道的安全性,而这些安全性可能很薄弱或根本不存在。

TrojAI将专注于向最终用户提供全面开发的人工智能的操作用例。该项目将测试来自多个领域的人工智能模型的执行解决方案,包括图像分类、自然语言、网络安全和强化学习,以探索解决方案的泛化。目标是提供易于集成的软件,可以在部署人工智能前快速、准确、可靠地检测其中的木马。

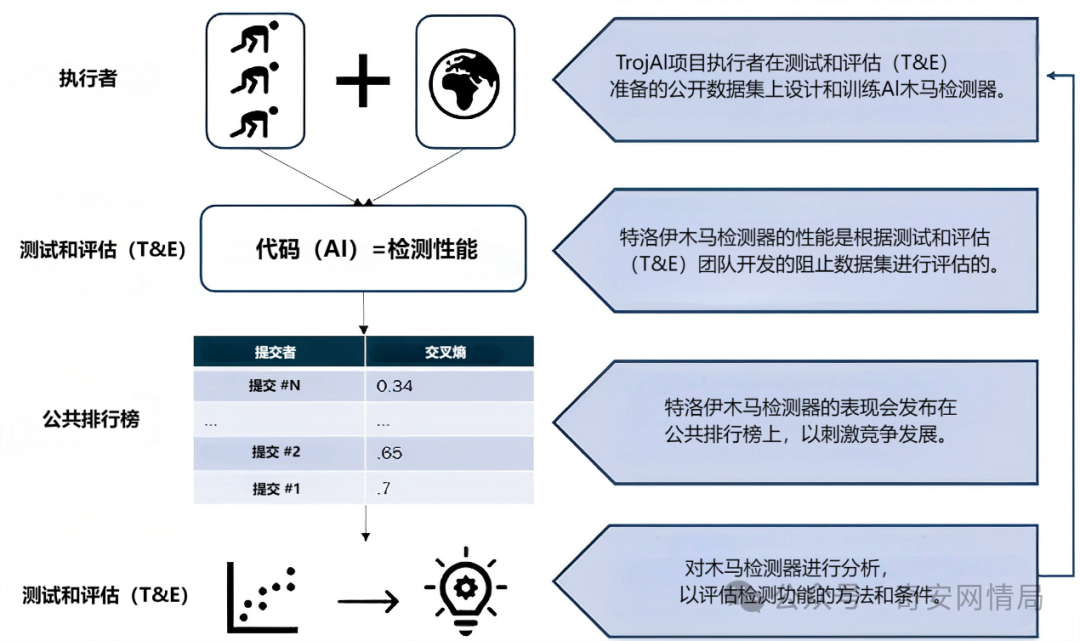

TrojAI方法:TrojAI执行者使用专门为特定应用设计的多个数据集开发特洛伊木马检测器。执行者进行迭代开发,并将结果公开发布在挑战赛排行榜上。在挑战赛结束时,T&E团队会分析提交结果以评估方法并描述检测器在多个应用领域的功能状况。