用AI检测AI合规?谷歌公开AI合规检查工具

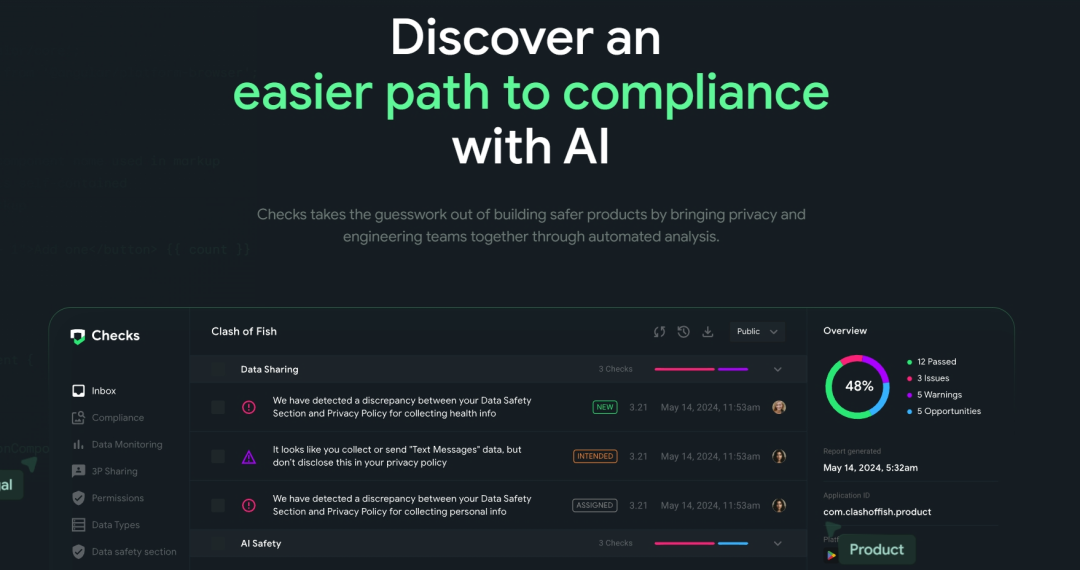

责编:gltian |2024-10-15 15:08:2010月10日消息,谷歌公开发布其内部工具“Checks”,该工具可以帮助评估应用程序、代码和AI是否符合各种标准和法规,以应对监管要求。

该工具最初在谷歌内部使用,现在可以公开使用,并专注于合规性的三个关键领域——应用程序合规(App Compliance)、代码合规(Code Compliance)和AI安全(AI Safety)。

01 主要功能

1.应用程序合规

应用程序合规性评估通过检查应用程序或网站,确保其遵守用户数据收集法规,这些法规例如欧盟GDPR(《通用数据保护条例》)、美国加州CCPA(《加州消费者隐私法案》)或巴西LGPD(《《通用数据保护法》》)。此外,它还可用于已经上线应用商店的应用程序。

整个“Checks”的系统基于AI大型语言模型运行,该模型经过微调,可理解不同的政策法规。因此,该系统通过检查这些政策并将其与应用程序或网站进行比对,并利用AI爬虫来检查应用程序的功能。

谷歌表示,虽然用户可以利用“Checks”获得法律见解,但其设计目并不是提供法律建议或支持,而是主要用于标准政策检查。

2.代码合规性

目前,代码合规性还处于封闭测试阶段。不过,它可以帮助编码人员在应用程序发布前检查监管问题。用户可以轻松地将其集成到开发环境中,并在构建系统时使用它来获知潜在的风险。此外,它还能检测如过时的SDK之类的关键问题。

3.AI安全

目前,AI行业的安全标准、道德和合规性仍在审查和评估中。例如,OpenAI正在为人工智能合规性和标准创建一个安全委员会。不过,要制定全行业的标准尚需时日。

由于人工智能系统是一个复杂的模型,因此通过谷歌的“Checks”工具对其进行全面评估具有一定的挑战性。谷歌正在进行密集的封闭测试,试图制定某些标准和政策以尽可能提供最好的合规性检查。

人工智能安全检查不仅可以进行合规性检查,它还可以协助检查来自大语言模型的表达、幻觉和有争议的声明或制作,比如那些带有偏见或种族色彩的输出结果。

02 “Checks”与AI安全

谷歌称,“Checks”建立了一个整体性运行框架可以覆盖开发人员使用AI产品时需要解决三个主要阶段的问题,分别是:

第一阶段“对齐阶段”:确定哪些政策法规与AI产品相关。

第二阶段“评估阶段”:确保初始模型版本可以完成开发所设定的预期任务。

“Checks”对AI模型进行“红队测试 ”和“提示词测试”,检测AI产品的是否存在安全隐患,并根据所选定的相关国家或地区法律法规检测AI产品在暴力、仇恨言论和敏感数据(如个人身份信息)方面的输出结果符合预期。

第三阶段“监控阶段”:在AI产品推出后,开发人员需要检查它在实际环境中可以正常、正确运行,确保不会被盗用或被黑客入侵。

例如,曾经有这样一个案例:一家公司推出了一个通用人工智能代理,为特定场景提供服务,但人们发现他们可以“黑”它,从而免费盗用这个模型,但这个模型的开发成本实际上非常高。

“Checks”可以监控输入提示和输出提示并检测问题,比如当有人试图对模型进行骇入时,输入提示就会被阻止到达模型;任何个人隐私数据的输出行为也都会被检测。

03 初始版本

“Checks by Google”早在2023年5月就在谷歌官方的一篇博客中被提及。

谷歌称在这篇博客中称,“Checks”最初于2022年作为Google内部孵化器的一部分推出,用于快速发现和解决Google Play和iOS商店中的应用程序的隐私合规性问题,该初始版本具有3个关键产品领域:

- 1.合规性监控(Compliance Monitoring)通过使用自动化测试来扫描应用程序及其隐私披露情况,帮助公司识别潜在的法规和移动应用商店合规性问题,并提供可操作的建议来帮助解决任何已发现的问题。

- 2.数据监控(Data Monitoring)提供应用程序数据收集和共享行为的端到端可见性,使开发运营团队能够更高效地、集成地管理其数据治理。

- 3.商店披露支持(Store Disclosure Support)可帮助公司确保其开发的程序符合Google Play数据安全要求。

来源|Checks官网

编译|尚健

审核|唐巧盈